對 AI 代理的投資增加,顯示未來自動化將普及,可能比工業革命更具變革性。與任何技術創新一樣,AI 代理在發展中必然會面臨問題。持續改進對於負責任的使用和實現 AI 代理的全部潛力至關重要。

在 Consensus Hong Kong,BeInCrypto 採訪了 DWF Labs 的管理合夥人 Andrei Grachev,討論 AI 代理在實現大規模採用時面臨的主要挑戰,以及普及使用可能的樣貌。

目前可以肯定地說,採用人工智慧 (AI) 很快將成為必然。科技巨頭如 Meta、Amazon、Alphabet 和 Microsoft 已宣布計劃在 2025 年投資高達 3200 億美元於 AI 和數據中心。

美國總統 特朗普宣布 Stargate,這是一個專注於 AI 數據中心開發的新私人合資企業。該企業由 OpenAI、Softbank 和 Oracle 組成,計劃在美國建設多達 20 個大型 AI 數據中心。

初始投資估計為 1000 億美元,擴展計劃可能使總額在 2029 年達到 5000 億美元。

Web3 項目也在 AI 上進行類似投資。12 月,領先的加密風險投資公司 DWF Labs 推出了一個 2000 萬美元的 AI 代理基金,以加速自主 AI 技術的創新。

本月早些時候,支持 NEAR 協議的 NEAR Foundation 也宣布了自己的 2000 萬美元基金,專注於擴展基於 NEAR 技術的全自動和可驗證代理的開發。

「歷史顯示,所有可以自動化的事物都將被自動化,肯定有一些商業和日常生活過程將被 AI 代理接管。」Grachev 告訴 BeInCrypto。

但隨著 AI 發展加速,其被濫用的潛力成為日益增長的擔憂。

AI 代理的惡意使用

在 Web3 中,AI 代理已迅速成為主流。它們提供多樣化的功能,從市場分析到自主加密交易。

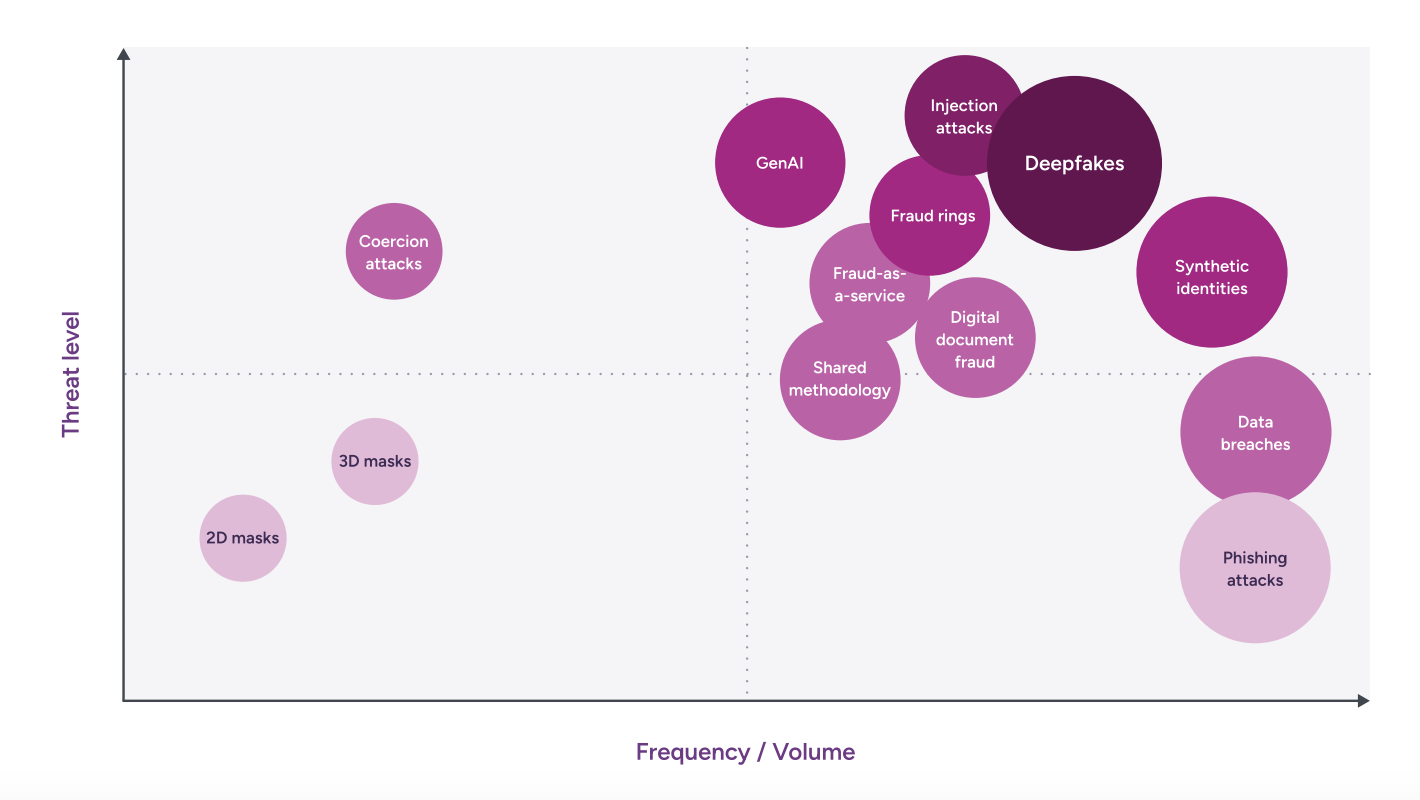

然而,它們的日益整合也帶來了重大挑戰。惡意行為者濫用 AI 是一個主要問題,涵蓋從簡單的網絡釣魚活動到複雜的勒索軟件攻擊的情況。

自 2022 年底以來,生成式 AI 的廣泛可用性從根本上改變了內容創作,同時也吸引了試圖利用該技術的惡意行為者。這種計算能力的民主化增強了對手的能力,並可能降低了不太複雜的威脅行為者的進入門檻。

根據 Entrust 的報告,由 AI 工具促成的數位文件偽造現已超過實體偽造,2024 年同比增長 244%。同時,深偽技術佔所有生物識別欺詐的 40%。

Grachev 說道:「它已經被用於詐騙。它被用於視頻通話中,誤導人們和偽造他們的聲音。」

這類剝削的例子已經成為新聞頭條。本月早些時候,香港一家跨國公司的金融工作者被騙,授權支付 2500 萬美元給使用深偽技術的詐騙者。

據報導,該工作者參加了一次視頻通話,與他認為是同事的人,包括公司的首席財務官。儘管最初猶豫不決,但在其他參與者看起來和聽起來都很真實後,他還是進行了付款。後來發現,所有參加者都是深偽偽造。

從早期採用到主流接受

Grachev 認為這種惡意使用是不可避免的。他指出,技術發展通常伴隨著初期錯誤,隨著技術成熟,這些錯誤會減少。Grachev 提出了兩個明顯的例子來證明他的觀點:萬維網和比特幣的早期階段。

他說道:「我們應該記住,互聯網是從色情網站開始的。這就像最初的比特幣,從毒品交易者開始,然後逐漸改善。」

多份報告支持 Grachev 的觀點。它們指出成人娛樂行業在互聯網的早期採用和發展中發揮了關鍵作用。除了提供消費者基礎外,它還開創了錄影機、視頻流、虛擬現實和任何形式的通信技術。

色情行業充當了引導工具。成人娛樂行業歷來推動了新技術的消費者採用。

其早期採用和應用創新,特別是在成功滿足觀眾需求時,往往會導致更廣泛的主流採用。

Grachev 說道:「它始於娛樂,但娛樂吸引了很多人。然後你可以在這個觀眾基礎上建立一些東西。」

隨著時間的推移,已經設置了保障措施來限制成人娛樂的頻率和可及性。儘管如此,它仍然是互聯網提供的多種服務之一。

比特幣:從暗網崛起到顛覆

比特幣的演變與互聯網的早期用例密切相關。比特幣的早期採用與暗網市場和非法活動密切相關,包括毒品交易、欺詐和洗錢。其匿名性和全球資金轉移的便利性使其對犯罪分子具有吸引力。

儘管比特幣仍被用於犯罪活動,但它已找到許多合法應用。支撐加密貨幣的區塊鏈技術為現實世界問題提供了解決方案,並顛覆了傳統金融系統。

雖然加密貨幣和區塊鏈應用仍然是非常新興的行業,但它們將繼續發展。根據 Garchev 的說法,人工智慧技術的逐步應用也將如此。對他來說,必須歡迎錯誤,以便從中學習並相應調整。

「我們應該始終記住,欺詐首先發生,然後人們才開始思考如何防止它。當然,這會發生,但這是一個正常的過程,是一個學習曲線。」Grachev 說道。

然而,知道這些情況將來會發生,也引發了關於誰應該承擔責任的問題。

責任問題

當因代理人的行為而造成損害時,確定責任是一個複雜的法律和道德問題。如何追究人工智慧的責任問題不可避免地出現。

人工智慧系統的複雜性在確定損害責任時帶來挑戰。其「黑箱」特性、不可預測的行為和持續學習能力使得在出現問題時難以應用典型的責任概念。

此外,人工智慧開發和部署涉及多方,這使得責任評估更加複雜,難以確定人工智慧失敗的責任。

責任可能在於製造商的設計或生產缺陷、軟體開發者的代碼問題,或用戶未遵循指示、安裝更新或維護安全。

「我認為整件事情太新了,我們應該能夠從中學習。我們應該能夠在需要時停止一些人工智慧代理。但在我看來,如果沒有惡意意圖,沒有人應該為此負責,因為這是全新的事物。」Grachev 告訴 BeInCrypto。

然而,根據他的說法,這些情況需要謹慎管理,以避免影響持續的創新。

Grachev 補充道:「如果你責怪這位企業家,創新將被扼殺,因為人們會害怕。但如果它以不好的方式運作,對吧,它最終可能會成功。我們需要有一種方法來停止它,學習,改進,然後重新學習。」

然而,這條界線仍然非常細微,尤其是在更極端的情況下。

解決信任問題促進負責任 AI 採用

討論人工智慧未來時,常見的恐懼是 AI 代理變得比人類更強大。

Grachev 說道:「有很多電影是關於這個的。如果我們談論警察或政府控制,或者某種戰爭中的軍隊,當然,自動化是一個大恐懼。有些事情可以自動化到如此大的程度,以至於它們可能會傷害人類。」

當被問及這種情況是否可能發生時,Grachev 說理論上是可能的。不過,他承認自己無法預知未來會發生什麼。

然而,這些情況象徵著人類與人工智慧之間的基本信任問題。Grachev 說,解決這個問題的最佳方法是讓人們接觸到 AI 實際有幫助的使用案例。

他說:「AI 可能讓人難以相信。這就是為什麼應該從簡單的事情開始,因為信任 AI 代理不會在有人解釋它值得信賴時建立。人們應該習慣使用它。例如,如果你談論加密貨幣,你可以在 Pump.fun 上發起一個迷因,但為什麼不通過語音信息發起呢?使用 AI 代理,只需發送語音信息說『請發起這個和那個』,然後就發起了。接下來的一步是信任代理做出一些更重要的決定。」

最終,邁向廣泛 AI 採用的旅程無疑將充滿顯著的進步和意想不到的挑戰。

在這個發展中的領域中,平衡創新與負責任的實施對於塑造一個 AI 造福全人類的未來至關重要。